图像深度网络定制

定制深度学习训练循环和损失函数

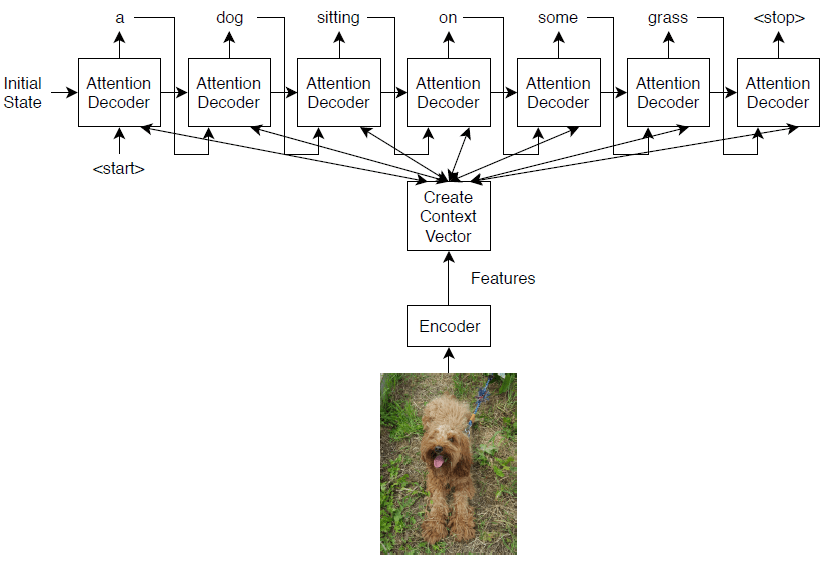

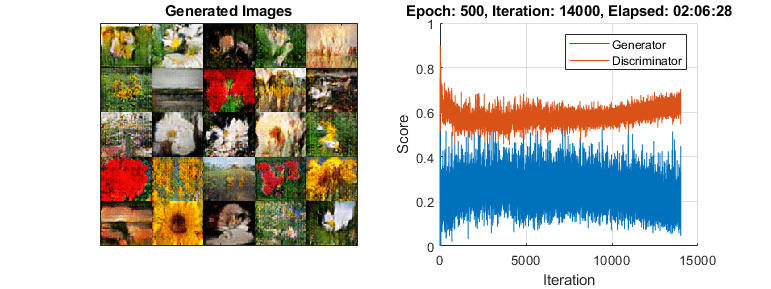

如果trainingOptions函数没有提供任务所需的训练选项,或者自定义输出层不支持所需的损耗函数,那么可以定义自定义训练循环。对于不能使用层图创建的网络,您可以将自定义网络定义为一个函数。要了解更多,请参见定义自定义训练循环,损失函数和网络.

功能

主题

- 使用自定义训练循环训练网络

这个例子展示了如何训练一个使用自定义学习速率计划对手写数字进行分类的网络。

- 多输入多输出网络

学习如何定义和训练具有多输入或多输出的深度学习网络。

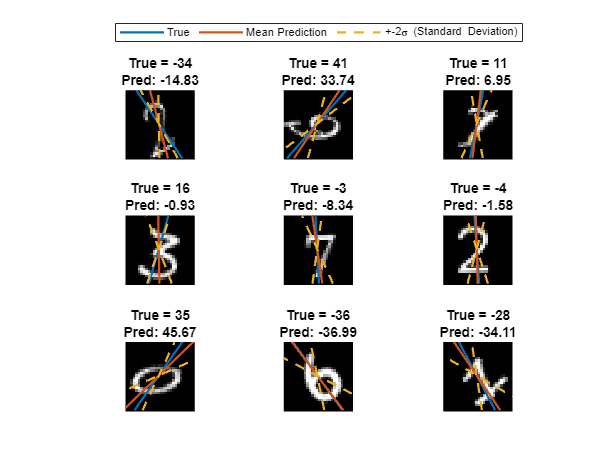

- 多输出训练网络

这个例子展示了如何训练一个具有多个输出的深度学习网络,预测手写数字的标签和旋转角度。

- 训练Siamese网络来比较图像

这个例子展示了如何训练Siamese网络来识别手写字符的相似图像。

- 示例深度学习网络架构

这个例子展示了如何为各种任务定义简单的深度学习神经网络。

- 用于深度学习的数据集

发现用于各种深度学习任务的数据集。