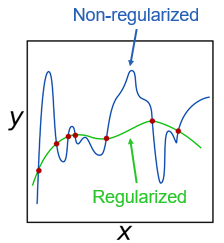

用正则化防止过拟合

正则化技术用于防止预测模型中的统计过拟合。正则化算法通常通过对复杂性施加惩罚(例如将模型系数添加到最小化中)或包括粗糙度惩罚来工作。通过在模型中引入额外的信息,正则化算法可以处理多重共线性和冗余预测器,使模型更加精简和准确。

流行的正则化技术包括岭回归(也称为Tikhonov正则化),套索和弹性网算法,收缩质心方法,以及迹图和交叉验证的均方误差。您还可以应用赤池信息标准(AIC)作为拟合优度度量。

每种正则化技术都为某些用例提供了优势。

- 套索使用L1范数,并倾向于迫使个别系数值完全趋近于零。因此,lasso作为一种特征选择算法效果非常好。它能快速识别出少量的关键变量。

- 岭回归系数使用L2范数(你在最小化误差平方和)。脊回归倾向于将系数收缩分散到更大数量的系数上。如果你认为你的模型应该包含大量的系数,岭回归可能是一个很好的技术。

- 弹性网可以弥补拉索无法识别额外的预测因素。

正则化与特征选择它迫使模型使用更少的预测器。正则化方法有一些明显的优点。

- 正则化技术能够在比大多数特征选择方法(单变量特征选择除外)更大的数据集上操作。套索和岭回归可以应用于包含数千甚至数万个变量的数据集。

- 正则化算法通常比特征选择生成更准确的预测模型。正则化操作在连续空间上,而特征选择操作在离散空间上。因此,正则化通常能够对模型进行微调,并产生更准确的估计。

然而,特征选择方法也有优点:

- 特性选择在某种程度上更直观,也更容易向第三方解释。当你在分享你的成果时必须描述你的方法时,这是很有价值的。

- MATLAB®而且统计和机器学习工具箱™支持所有流行的正则化技术,并可用于线性回归、逻辑回归、支持向量机和线性判别分析。如果您正在使用其他模型类型,如增强决策树,则需要应用特征选择。

要点

- 使用正则化(与特征选择一起)来防止预测模型中的统计过拟合。

- 由于正则化在连续空间上运行,它可以在机器学习问题上优于离散特征选择,这些问题适用于各种线性建模。

例子和如何

软件参考

正则化对函数y=f(x)的作用